INNOVAZIONE

Cosimo Accoto

Gennaio 2025

Alla ricerca di umane verità perdute

L’arrivo dell’intelligenza artificiale generativa istanzia, di fatto, una nuova era mediale inflazionaria in virtù della conflagrazione simulativa di linguaggi sintetici, immagini artificiali, agenti autonomi. Il che produce filosoficamente e operativamente uno scardinamento insidioso dei regimi di verità e falsità storicamente dati e agiti fino ad oggi, oltre che sancire un attacco culturale profondo alla rappresentazione della realtà, anch’essa storicamente prodotta e connotata. Già collassati nell’era della post-verità, come ne usciamo da questa nuova crisi epistemica?

Insieme alla temuta catastrofe, si sta fortunatamente avvertendo anche la necessità politico-sociale (ed economica) di ricostruire, in qualche modo e in forme nuove, il senso e la pratica della “verità” e quindi lo stimolo alla progettazione e creazione delle condizioni sociotecniche della sua possibilità (condizioni di esistenza, di esperienza, di intelligenza). Che a ben guardare sono, da ultimo, anche questioni di dinamica politica e gestione del potere. Conseguenza attesa, naturalmente, di questo cambio sono i connessi impegni e impatti umani rispetto a futuri e nuovi regimi di verificazione e falsificazione.

È in questa prospettiva che dobbiamo, allora, leggere gli sforzi ingegneristici attuali di certificare e discriminare l’umano dalla macchina, il vero dal falso, l’originale dalla copia, il fatto dal contraffatto. Occorre, però, comprendere che il nuovo “vero” si istanzierà con innovative configurazioni. Vale a dire, come processo-evento di una stratificazione (stack) di protocolli e primitive che presiederanno (con nuovi assemblaggi umani-macchine) alla produzione, circolazione e conservazione della “verità” del mondo. E, con questa, di molti dei suoi derivati come: qualità, autenticità, autorialità, credibilità, affidabilità, assicurabilità e così via.

Dentro le nuove ingegnerie del vero

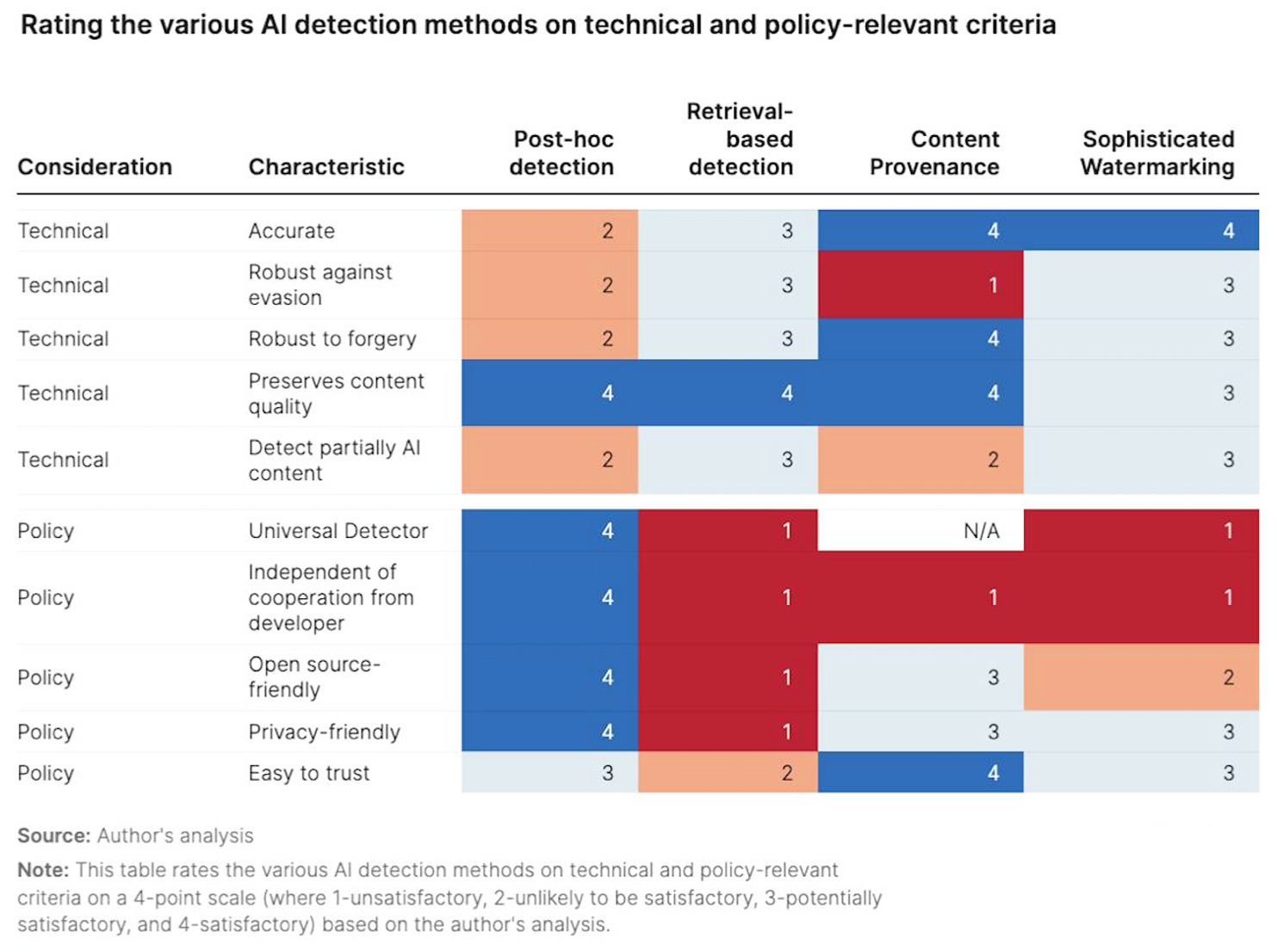

È in accelerazione, dunque, lo sviluppo di soluzioni tecniche (sophisticated watermarking, content provenance, retrieval-based detection, post-hoc detection: vedi la figura tratta da Siddarth Srinivan, Brookings 2024) e standard computazionali condivisi che cercano di contemperare, in qualche misura, technology e policy, robustezza tecnologica e validazione sociale. Dunque, marcatori statistici, impronte crittografiche, tracciatori di provenienza, algoritmi avversativi sono alcuni degli strumenti allo studio per questa nuova “caccia alla verità”.

Come si comprende facilmente, attraversare (e abitare già in qualche senso) queste nuove uncanny valley (situazioni disturbanti e disagevoli) si preannuncia come una sfida politica planetaria, complessa e arrischiata. Uno sforzo erculeo tanto quanto (qualcuno paventa) sisifeo: sistemi ingegneristicamente complicati a farsi e, però, anche spesso facili a essere aggirati in una gara senza esclusione di colpi e senza possibilità di tregue tra verificatori e falsificatori. Più in generale, poi, sarà necessario farsi carico di tutte le fasi della “produzione del vero”: la certificazione, la conservazione, la circolazione. Dunque, come si validerà il “vero”? Come lo si preserverà? Come lo si diffonderà?

Sulla verificazione, intelligenza artificiale e crittografia informatica sono candidate a essere strumenti chiave per certificare l’autenticità di un contenuto o la proprietà di un bene. Sull’archiviazione, le architetture di tipo blockchain si propongono, invece, di divenire i dispositivi della conservazione digitale protetta di media news e virtual asset. Infine, sulla circolazione, sappiamo che oggi è in capo alle piattaforme delle big tech. Che, però, hanno anche la capacità massima di amplificazione del falso. A ben guardare, infatti, non è la semplice creazione del fake che ci dovrebbe preoccupare maggiormente, quanto la sua circolazione sociale e politica facile, automatizzata, massiva e capillare.

Dalle vulnerabilità alle immunità

Sono le piattaforme, di fatto, che producono quell’inquinamento informativo che gli economisti individuano sempre più come esternalità negativa dei rispettivi modelli di business. Da qui, l’urgenza di disegnare mercati dell’informazione migliori di quelli attuali, fortemente compromessi e inquinati. Impiegando e promuovendo, ad esempio, meccanismi economici di incentivo e disincentivo per ri-orientare una produzione informativa oggi inquinante (in analogia a quanto abbiamo fatto in passato per le imprese che producevano inquinamento ambientale). Riusciremo nell’opera ardua di creare nuovi mercati dell’informazione più sani o sarà anche questa una fatica erculea e sisifea?

Naturalmente tutto questo apre anche una più radicale provocazione di senso dell’IA. Sono e saranno le macchine (ovvero, i nuovi intrecci umano-macchinici cognitivi e decisionali all’opera) a discriminare il vero dal falso e non più, in prima istanza, il nostro sensorium, il nostro apparato di sensi e pensieri? In realtà, se ci facciamo caso, già accade così: dai server di posta elettronica che separano le e-mail utili dallo spam infastidente, ai data center bancari che distinguono gli accessi finanziari legittimi da quelli fraudolenti e criminali. Sono già le macchine, dunque, a tenere sano e sicuro il pianeta Terra digitale, dalla posta elettronica ai conti digitali.

Avremo anche architetture informatiche che certificheranno notizie vere rispetto alle fake news attraverso nuove “macchine della verità”? Tra watermarking (filigrane statistiche), fingerprinting (marcatori crittografici) e metadati (etichette di dati), la condizione informativa umana, politica e ingegneristica insieme è nuovamente e arrischiatamente chiamata in questione e provocata nel suo significato. E però, direi, che si è innescata anche una trasformazione strategica di economie e modelli di business. In effetti, se cambiano le vulnerabilità, dovranno di necessità cambiare anche le immunità.

Il rischio tra strategia e cultura

Così le strategie tradizionali di respingimento, di contenimento e di risarcimento del rischio andranno aggiornate e potenziate, se non proprio radicalmente innovate, anche in termini di cyberinsurance. Presto, ad esempio, tutte le tradizionali forme di rischio/assicurazione saranno forme nuove di rischio cibernetico: dagli incidenti per strada ai furti in casa, dalla salute al terrorismo. E, quindi, anche il business tradizionale dell’assicurazione e dell’affidabilità si prepara a un cambio di paradigma epocale. Il ruolo dell’assicurazione si modifica per policyholder e policymaker al fine di implementare strategie di governance e modelli integrativi e preventivi e non più solo riparativi a valle del danno come è stato finora.

Certamente, il fronte intellettuale del “rischio esistenziale” dell’IA mi sembra oggi in via di ridimensionamento rispetto al clamore mediatico di qualche mese fa. L’orientamento dell’oggi è più sui rischi “non-esistenziali”, diremmo per contrapposizione, più immediati e urgenti: discriminazione, manipolazione, alienazione, sostituzione. Ed è giusto, naturalmente, dare attenzione alle vulnerabilità più immediate, concrete e già testimoniate dai fatti senza farci distrarre da immaginazioni cinematografiche catastrofiste. E cercare, ovviamente, le nuove immunità necessarie.

E, tuttavia, la visione di corto raggio sull’immediato deve essere accompagnata dalla giusta prospettiva culturale sul cambio profondo che vivremo. Quindi, non dovremo solo imparare a gestire strategicamente il “calcolo del rischio” (risk management), ma più esistenzialmente il “rischio del calcolo” (computation failure). Cioè, proprio, l’essere arrischiato nativo della computazione che oggi sempre più si fa mondo. Come scrivevamo qualche tempo fa su questa rivista, a rischio è il mondo nel suo esser-ci in quanto esser-C, in quanto programmabile informaticamente.

Cosimo Accoto, filosofo, research affiliate e fellow (MIT), adjunct professor (UNIMORE), è autore di una trilogia filosofica sul mondo digitale: Il mondo in sintesi, Il mondo ex machina, Il mondo dato. The Latent Planet (2024) è il suo ultimo saggio breve.